|

|

Website-Scraper-Befehlszeilenautomatisierung

Automatisieren Sie das Website-Scraping im A1 Website Scraper. Laden Sie Websites automatisiert herunter, z. B. nachts.

Befehlszeilenunterstützung im A1 Website Scraper

Sie können eine Befehlszeilenschnittstelle verwenden, um alle wichtigen Website-Scraper-Tools im Programm zu automatisieren.

Dies bedeutet, dass Sie auch externe Anwendungen und Bat-/Batch-/Skriptdateien verwenden können.

Dadurch können Sie unsere Website-Scraper-Software in regelmäßigen Abständen ausführen, z. B. mit dem Windows-Taskplaner.

Dies bedeutet, dass Sie auch externe Anwendungen und Bat-/Batch-/Skriptdateien verwenden können.

Dadurch können Sie unsere Website-Scraper-Software in regelmäßigen Abständen ausführen, z. B. mit dem Windows-Taskplaner.

- Parameter:

- " :%project-path% " : Wobei %project-path% den Pfad der aktiven Projektdatei enthalten sollte. (Denken Sie an den Doppelpunkt vor dem Projektpfad.)

- " @override_initfromproject=c:\example\projects\initfrom.ini@ " : Überschreibt die ursprünglich verwendeten Projekteinstellungen.

- " @override_rootpath=http://example.com@ " : Website-Stammpfad überschreiben.

- „ -autocreate “: Projektdateien und zugehörige Dateien automatisch erstellen, wenn sie noch nicht vorhanden sind.

- „ -exit “: Wird beendet, wenn der Vorgang abgeschlossen ist.

- „ -hide “: Immer unsichtbar und wird beendet, wenn Sie fertig sind.

- „ -scan “: Führt den Website-Scanner aus.

- „ -stop 0000 „ : Stoppt den Scan nach einigen Sekunden, z. B. -stop600 stoppt den Scan nach 10 Minuten.

- „ -stopurls 0000 “ : Stoppt den Scan, nachdem eine Reihe von URLs gefunden und verarbeitet wurden, z. B. -stopurls500.

- „ -save “: Speichert das Projekt.

- " @override_exportpathdir=c:\example\exports\@ " : Überschreibe den allgemeinen Verzeichnispfad, der beispielsweise für CSV-Exportdatendateien verwendet wird.

- „ -exportexternalcsv “ : Exportiert alle in der Baumansicht „extern“ aufgeführten URL-Daten in eine Datei namens „external.csv“, die sich im Projektverzeichnis befindet.

- „ -exportinternalcsv “ : Exportiert alle in der „internen“ Baumansicht aufgeführten URL-Daten in eine Datei namens „internal.csv“, die sich im Projektverzeichnis befindet.

- „ -exportsitemapcsv “ : Exportiert alle in der „internen“ Baumansicht aufgelisteten URL-Daten in eine Datei namens „sitemap.csv“, die sich im Projektverzeichnis befindet.

- „ -scrapesinglepage “ : Scrapen Sie nur die durch die URL einer einzelnen Seite definierten Scraper-Optionen – nützlich, wenn Sie nur Daten von einer einzelnen Seite möchten.

- Beispiele für den Einsatz unter Windows:

- [ „c:\microsys\website\scraper.exe“ -exit -scan -build -save „:c:\microsys\website\scraper\my-project.ini“ ].

- [ „Scraper.exe“ -exit -scrapesinglepage „:my-project.ini“ ] – Hier wird davon ausgegangen, dass sich my-project.ini im selben Verzeichnis wie die ausführbare Datei befindet.

- [ „Scraper.exe“ -scan -build @override_rootpath=http://example.com@ ]

- [ start "" "Scraper.exe" -scan -build @override_rootpath=http://example.com@ ] – Wird asynchron gestartet. Verwenden Sie in Parametern keine Leerzeichen.

[ timeout 2 ] – Leerlaufzeit, um Probleme beim gleichzeitigen Start mehrerer Instanzen zu vermeiden.

- Beispiele für den Einsatz unter Mac OS:

- [ open -n A1WebsiteScraper.app --args -scan -build @override_rootpath=http://example.com@ ].

- [ open -n A1WebsiteScraper.app --args -exit -scan -save -autocreate ":/users/%name%/myprojects/shopexample.ini" @override_initfromproject=/users/%name%/myprojecs/mydefaults.ini@ @ override_rootpath=https://shop.example.com@ ].

- Tipps:

- Um zu verhindern, dass ein Parameterwert, der Leerzeichen enthält (z. B. wenn Sie einen Verzeichnispfad übergeben), aufgeteilt wird, schließen Sie ihn in ein paar „“ ein.

- In den obigen Beispielen bezieht sich

%name%auf Ihren Benutzernamen im angegebenen Betriebssystem.

Automatisieren Sie Website Scraper mit Befehlszeile und Batch-Dateien

- Erstellen Sie eine Batch-Datei mit einem beliebigen Standard-Texteditor:

- Windows: Batchdatei.bat

- Mac: Batchdatei.Befehl

- Beispiel dafür, was unterstrichen geschrieben werden soll:

- Windows: [ „c:\microsys\website\scraper.exe“ -exit -scan -build -save „:c:\microsys\website\scraper\my-project.ini“ ].

- Mac: [ open -n A1WebsiteScraper.app --args -scan -build @override_rootpath=http://example.com@ ].

- Speichern Sie Ihre Batchdatei. Sie können es nun selbst oder von anderen Programmen und Skripten aus aufrufen.

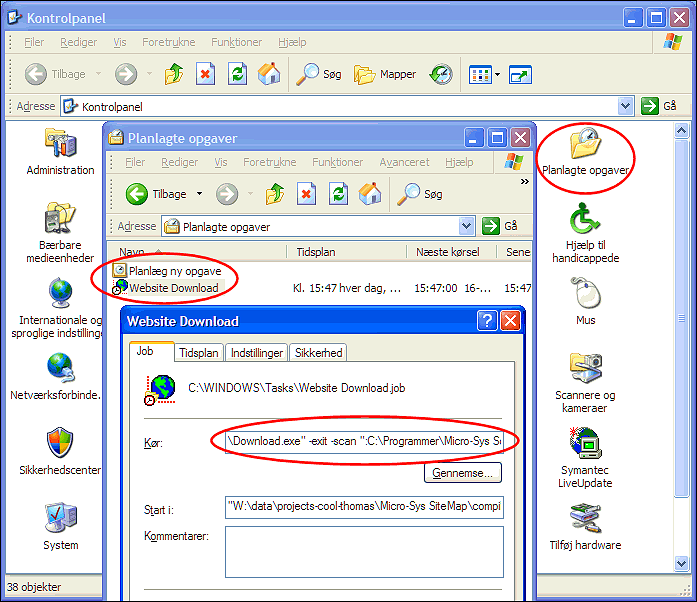

Planen und automatisieren Sie Website Scraper mit dem Windows-Taskplaner

- Öffnen Sie die Systemsteuerung | Geplante Aufgaben | Geplante Aufgabe hinzufügen. Folgen Sie der Anleitung.

- Öffnen Sie das generierte Website-Scraper-Zeitplanungselement, um Details zu bearbeiten, z. B. Befehlszeilenparameter.