|

|

Crawlen Sie große Websites mit dem A1 Website Analyzer

Verbessern Sie die Crawler-Geschwindigkeit und die Speichernutzung während des Site-Scans mit unserer Website-Analysesoftware.

Häufige Website-Gründe für die Crawler-Speichernutzung

Wenn A1 Website Analyzer beim Scannen einfriert, weil mehr Speicher benötigt wird (oder eine bessere Konfiguration erforderlich ist), sollten Sie zunächst prüfen, ob die Ursache und Lösung auf der Website liegt.

Liste der zu überprüfenden Dinge:

Hinweis: Wenn Sie erweiterte Hilfe bei der Analyse Ihrer Website auf Probleme benötigen, bieten wir auch Sitemap- und SEO-Dienste an.

Liste der zu überprüfenden Dinge:

- Überprüfen Sie, ob Ihre Website unendlich viele eindeutige URLs generiert. Wenn dies der Fall ist, stoppt der Crawler nie, da ständig neue eindeutige Seiten-URLs gefunden werden. Eine gute Methode, diese Art von Problemen zu entdecken und zu lösen, ist:

- Starten Sie einen Website-Scan.

- Stoppen Sie den Website-Scan beispielsweise nach einer halben Stunde.

- Überprüfen Sie, ob alles korrekt erscheint, dh ob die meisten der gefundenen URLs korrekt erscheinen.

Beispiel 1

Eine Website gibt für fehlerhafte Seiten-URLs 200 statt 404 zurück. Beispiel für ein unendliches Muster:

Ursprüngliche 1/broken.html -Links zu 1/1/broken.html -Links zu 1/1/1/broken.html usw.

Beispiel #2

Das Website-Plattform-CMS generiert eine große Anzahl von 100 % doppelten URLs für jede tatsächlich vorhandene URL. Weitere Informationen zu doppelten URLs finden Sie auf dieser Hilfeseite. Denken Sie daran, dass Sie interne Website-Links analysieren und untersuchen können, falls etwas nicht stimmt. - Überprüfen Sie, ob Ihre Projektkonfiguration und der Inhalt Ihrer Website dazu führen, dass der Crawler Dateien mit einer Größe von mehreren Hundert Megabyte herunterlädt.

Beispiel Nr. 1: Ihre Website enthält viele große Dateien (z. B. Hunderte Megabyte), die der Crawler herunterladen muss. (Während der Speicher nach Abschluss des Downloads freigegeben wird, kann es auf Computern mit wenig Speicher dennoch zu Problemen kommen.)

Hinweis: Wenn Sie erweiterte Hilfe bei der Analyse Ihrer Website auf Probleme benötigen, bieten wir auch Sitemap- und SEO-Dienste an.

Crawler-Geschwindigkeit und Webserver-Leistung

Die Geschwindigkeit des Webservers und der Datenbank ist wichtig, wenn Sie datenbankgenerierte Inhalte verwenden. Foren, Portale und CMS-basierte Websites lösen häufig viele SQL-Abfragen pro HTTP-Anfrage aus. Basierend auf unserer Erfahrung sind hier einige Beispiele für Leistungsengpässe bei Webservern:

Überprüfen Sie, ob die Datenbankleistung der primäre Engpass ist, wenn sie von vielen gleichzeitigen Verbindungen und Abfragen betroffen ist. Stellen Sie außerdem sicher, dass die Datenbank nicht auf maximal gleichzeitige Benutzer/Anfragen beschränkt ist (z. B. durch die Lizenz).

Wenn Sie Dateien/Ressourcen lesen/schreiben, kann dies andere Verbindungen blockieren, wenn diese Zugriff auf dieselben Ressourcen benötigen.

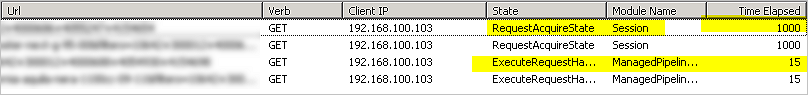

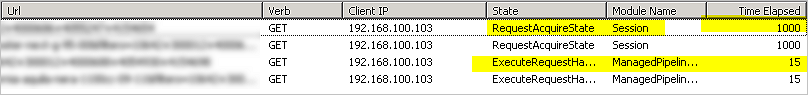

Auf dem IIS- Webserver kann das Lesen/Schreiben von Sitzungsinformationen mithilfe eines Sperrmechanismus in die Warteschlange gestellt werden. Dies kann zu Problemen führen, wenn eine hohe Last von HTTP-Anforderungen aus derselben Crawler- Sitzung auf vielen Seiten gleichzeitig verarbeitet wird.

Überprüfen Sie die Protokolle Ihres Webservers und scannen Sie Ihre Website zu Zeiten mit geringer Bandbreitennutzung.

Datenbank

Überprüfen Sie, ob die Datenbankleistung der primäre Engpass ist, wenn sie von vielen gleichzeitigen Verbindungen und Abfragen betroffen ist. Stellen Sie außerdem sicher, dass die Datenbank nicht auf maximal gleichzeitige Benutzer/Anfragen beschränkt ist (z. B. durch die Lizenz).

Ressourcen und Dateien

Wenn Sie Dateien/Ressourcen lesen/schreiben, kann dies andere Verbindungen blockieren, wenn diese Zugriff auf dieselben Ressourcen benötigen.

Ressourcen und Sitzungen

Auf dem IIS- Webserver kann das Lesen/Schreiben von Sitzungsinformationen mithilfe eines Sperrmechanismus in die Warteschlange gestellt werden. Dies kann zu Problemen führen, wenn eine hohe Last von HTTP-Anforderungen aus derselben Crawler- Sitzung auf vielen Seiten gleichzeitig verarbeitet wird.

Scannen Sie, wenn der Verkehr gering ist

Überprüfen Sie die Protokolle Ihres Webservers und scannen Sie Ihre Website zu Zeiten mit geringer Bandbreitennutzung.

- Mit unserer Website-Analysesoftware können Sie Website-Scans automatisieren.

Auswahl der richtigen ausführbaren Datei

Die Setup-Datei des A1 Website Analyzer installiert mehrere ausführbare Dateien im Programminstallationsverzeichnis, die jeweils für verschiedene Systeme optimiert sind. Während die Setup-Installation diejenige auswählt, die am besten zu Ihrem Computersystem passt, möchten Sie möglicherweise eine der anderen verwenden, falls die Speicherauslastung zu hoch ist.

Die Liste der installierten ausführbaren Dateien:

Die Liste der installierten ausführbaren Dateien:

- Analyzer_64b_UC.exe / Analyzer_64b_W2K.exe:

- Volle Unterstützung von Unicode mit 64-Bit-ausführbarer Datei.

- Mindestanforderungen: Windows XP / 64bit.

- Größte Speichernutzung, kann aber bei Verfügbarkeit auch auf viel mehr Speicher zugreifen.

- Analyzer_32b_UC.exe / Analyzer_32b_W2K.exe:

- Volle Unterstützung von Unicode mit ausführbarer 32-Bit-Datei.

- Mindestanforderungen: Je nach Version entweder Windows XP / 32 Bit oder Windows 2000 / 32 Bit.

- Etwas geringerer Speicherverbrauch.

- Analyzer_32b_CP.exe / Analyzer_32b_W9xNT4.exe:

- Etwas Unterstützung von Unicode mit ausführbarer 32-Bit-Datei.

- Mindestanforderungen: Windows 98 / 32bit.

- Geringster Speicherverbrauch.

Crawler-Konfiguration

Das Ändern von Einstellungen kann einen großen Unterschied machen, wenn Sie Probleme haben wie:

Reduzieren Sie die Gesamt- und/oder Spitzenressourcennutzung auf dem Crawler-Computer:

Reduzieren Sie die Gesamtressourcennutzung auf Crawler- und Webserver-Computern:

Reduzieren Sie die Spitzenressourcenauslastung auf Crawler- und Webserver-Computern:

Bei Verwendung der Funktion zum Anhalten / Fortsetzen des Website-Scans:

Reduzieren Sie die Ressourcennutzung auf dem Webserver-Computer:

Dinge, die sich auf die Ressourcennutzung sowohl auf dem Server als auch auf dem Desktop auswirken können:

Bonus-Tipp: Wenn Sie eine große Website haben, kann es oft eine gute Idee sein, ein paar Testscans durchzuführen. Auf diese Weise können Sie URL-Ausschlussfilter konfigurieren, bevor Sie mit einem größeren Website-Crawling beginnen.

- Das Scannen der Website geht sehr langsam.

- Der Webserver bricht Verbindungen ab und verhindert, dass der Crawler alle Seiten abrufen kann.

- Sie haben große Websites mit 10.000 oder 100.000 (+) Seiten, die Sie scannen möchten.

Reduzieren Sie die Gesamt- und/oder Spitzenressourcennutzung auf dem Crawler-Computer:

- Website scannen deaktivieren | Datenerfassung | Erstellen Sie eine Protokolldatei der Website-Scans

- Website scannen deaktivieren | Datenerfassung | Überprüfen Sie, ob externe URLs vorhanden sind

- Website scannen deaktivieren | Datenerfassung | Gefundene externe URLs speichern

- Website scannen deaktivieren | Datenerfassung | Speichern Sie Weiterleitungen, Links von und zu allen Seiten usw.

- Website scannen deaktivieren | Datenerfassung | Hinterlegen Sie zusätzliche Details (z. B. in welcher Zeile im URL-Inhalt ein Link platziert ist)

- Website scannen deaktivieren | Datenerfassung | Überprüfen Sie URLs, um ggf. die Sprache zu erkennen und zu identifizieren

- Website scannen deaktivieren | Datenerfassung | Speichern Sie Titel für alle Seiten

- Website scannen deaktivieren | Datenerfassung | Speichern Sie die „Meta“-Beschreibung für alle Seiten

- Website scannen deaktivieren | Datenerfassung | Speichern Sie „Meta“-Schlüsselwörter für alle Seiten

- Website scannen deaktivieren | Datenerfassung | Speichern und verwenden Sie bei Bedarf „Fallback“-Tags für Titel und Beschreibung

- Website scannen deaktivieren | Datenerfassung | Hinterlegen Sie Ankertext für alle Links

- Website scannen deaktivieren | Datenerfassung | Speichern Sie das „alt“-Attribut aller „uses“

- Website scannen deaktivieren | Datenerfassung | Speicherung von Antwortheadern

- Website scannen deaktivieren | Datenerfassung | Führen Sie eine Keyword-Dichteanalyse aller Seiten durch

- Website scannen deaktivieren | Datenerfassung | Speichern Sie H1 und H2 für alle Seiten

- Website scannen deaktivieren | Crawler-Optionen | Crawlen Sie Fehlerseiten

- Website scannen deaktivieren | Crawler-Optionen | Cookies zulassen

- Website scannen deaktivieren | Webmaster-Filter | Befolgen Sie die Anweisung „Crawl-Verzögerung“ in der Datei „robots.txt“.

- Erwägen Sie, Website scannen | auszuprobieren Raupenmotor | HTTP mit WinInet-Engine und -Einstellungen (Internet Explorer)

- Deaktivieren Sie im oberen Menü Extras | Nach Website-Scans: Zusammenfassende Daten berechnen (erweitert)

- Deaktivieren Sie im oberen Menü Extras | Nach Website-Scans: Daten öffnen und anzeigen

Reduzieren Sie die Gesamtressourcennutzung auf Crawler- und Webserver-Computern:

- In Website scannen | Analysefilter und Website scannen | Ausgabefilter ;

- Konfigurieren Sie, welche Verzeichnisse und Seiten der Website-Crawler ignorieren kann:

- Viele Foren generieren Seiten mit ähnlichem oder doppeltem Inhalt.

- Durch das Ausschließen von URLs können viele HTTP-Anfragen und Bandbreite eingespart werden.

- Weitere Informationen zu Analysefiltern und Ausgabefiltern finden Sie in der Hilfe.

- Folgendes passiert, wenn eine URL ausgeschlossen wird:

- Nur Analysefilter: Standardmäßig HEAD statt GET für HTTP-Anfragen

- Nur Ausgabefilter: Standardmäßig wird die ausgeschlossene URL entfernt, nachdem das Website-Crawling abgeschlossen ist.

- Sowohl Analysefilter als auch Ausgabefilter: Überhaupt keine HTTP-Anfrage an die ausgeschlossene URL.

- Konfigurieren Sie, welche Verzeichnisse und Seiten der Website-Crawler ignorieren kann:

Reduzieren Sie die Spitzenressourcenauslastung auf Crawler- und Webserver-Computern:

- In Website scannen | Raupenmotor

- Max. gleichzeitige Verbindungen (Datenübertragung):

- Richten Sie ein, ob das Webserver-Backend und Ihre eigene Bandbreite mehr Anfragen verarbeiten können.

- Legen Sie fest, ob das Webserver-Backend (z. B. Datenbankabfragen) einen Engpass darstellt.

- Max. Worker-Threads (Übertragung, Analyse usw.):

- Richten Sie ein, ob die CPU Ihres eigenen Computers mehr Arbeit bewältigen kann.

- Legen Sie es fest, wenn Sie andere Arbeiten an Ihrem Computer ausführen.

- Passen Sie die Timeout-Optionen an:

- Millisekunden, die gewartet werden müssen, bevor das Lesezeitlimit überschritten wird.

- Millisekunden, die gewartet werden müssen, bevor die Verbindung abbricht.

- Verbindungsversuche vor dem Aufgeben.

- So ändern Sie die Änderungseinstellungen:

- Richten Sie es ein, wenn Sie sicherstellen möchten, dass Sie alle Links und Seiten abrufen.

- Legen Sie fest, ob der Website-Scan so schnell wie möglich erfolgen soll.

- Aktivieren/deaktivieren Sie die Verwendung dauerhafter Verbindungen.

- Aktivieren/deaktivieren Sie die GZip- Komprimierung aller zwischen Crawler und Server übertragenen Daten.

- Aktivieren/deaktivieren Sie dauerhafte Verbindungen, die sich auf die Kommunikation zwischen Client und Server auswirken.

- Experimentieren Sie in der Option „Standardpfadtyp und Handler“ zwischen der Verwendung von Indy und WinInet für HTTP.

- Max. gleichzeitige Verbindungen (Datenübertragung):

Bei Verwendung der Funktion zum Anhalten / Fortsetzen des Website-Scans:

- In Website scannen | Ausgabefilter:

- Weitere Informationen finden Sie in der Hilfe zu Ausgabefiltern.

- Deaktivieren Sie Website scannen | Ausgabefilter | Nachdem der Website-Scan beendet wurde: Ausgeschlossene URLs entfernen:

- Bewirkt, dass der Website-Crawler alle URLs behält. Dadurch wird sichergestellt, dass keine URL mehr als einmal getestet wird.

- In Website scannen | Webmaster-Filter:

- Weitere Informationen finden Sie in der Hilfe zu Webmaster-Filtern.

- Deaktivieren Sie Website scannen | Webmaster-Filter | Nachdem der Website-Scan beendet wurde: URLs mit noindex/disallow entfernen:

- Bewirkt, dass der Website-Crawler alle URLs behält. Dadurch wird sichergestellt, dass keine URL mehr als einmal getestet wird.

- Nachfolgend erfahren Sie mehr über GET- und HEAD- Anfragen und wie sich dies auf die Effizienz des Lebenslaufs auswirken kann.

Reduzieren Sie die Ressourcennutzung auf dem Webserver-Computer:

- Nutzen Sie eine Content-Delivery-Network- Lösung (kurz CDN), um Inhalte zu servern, ohne Ihren eigenen Server zu belasten.

Dinge, die sich auf die Ressourcennutzung sowohl auf dem Server als auch auf dem Desktop auswirken können:

- In Website scannen | Raupenmotor

- Aktivieren/deaktivieren Sie die Verwendung von GET- Anfragen (anstelle von HEAD gefolgt von GET ). Wenn Sie die Lebenslauffunktion nutzen möchten, sollten Sie die Verwendung von HEAD- Anfragen aktivieren, da der Website-Crawler so gefundene URLs schnell auflösen kann. Dies wiederum beschleunigt die Anzahl der vollständig analysierten Seiten. Aufgrund der Interna der Crawler-Engine kann die Verwendung von HEAD auch die Speichernutzung reduzieren.

Bonus-Tipp: Wenn Sie eine große Website haben, kann es oft eine gute Idee sein, ein paar Testscans durchzuführen. Auf diese Weise können Sie URL-Ausschlussfilter konfigurieren, bevor Sie mit einem größeren Website-Crawling beginnen.

Projektdateien und Projektdatenspeicherung

- Wenn Sie Probleme beim Laden eines Website-Projekts mit erweiterten Website-Daten haben:

- Projektdaten werden in einem Unterverzeichnis der Projektdatei gespeichert.

- Projektdatei: c:\example\projects\demo.ini.

- Projektdatenverzeichnis: c:\example\projects\demo\.

- Projektdateien löschen, die erweiterte Website-Daten enthalten:

- hotarea-normal-ex.xml.

- hotarea-external-ex.xml.

- Versuchen Sie erneut, die Projektdatei zu laden.

- Projektdaten werden in einem Unterverzeichnis der Projektdatei gespeichert.

- Verbessern Sie die Geschwindigkeit und Speichernutzung beim Speichern/Laden von Projekten:

- Im oberen Menü Optionen zum Speichern/Laden des Projekts:

- Nutzen Sie eine optimierte XML-Datenspeicherung.

- Erweiterte Website-Daten ausschließen.

- Beschränken Sie die Daten auf Sitemap-URLs.

- Im oberen Menü Optionen zum Speichern/Laden des Projekts:

Ihre Computerkonfiguration

- Je größer die Website, desto wichtiger wird der Speicher.

- Hardwarespeicher ist viel schneller als virtueller Speicher.

- Beim Website-Scan werden viele Daten im Speicher gespeichert.

- Wenn Sie eine riesige Website haben, sollten Sie darüber nachdenken, den Speicheradressraum zu vergrößern, wie in einem eigenen Abschnitt weiter unten erläutert.

- Wenn Sie Probleme mit der Bandbreite haben, können Sie Folgendes versuchen:

- Führen Sie Website-Scans nachts durch, wenn Ihr ISP nur wenige Online-Benutzer hat.

- Stellen Sie sicher, dass keine Download- Anwendungen ausgeführt werden.

Erhöhen Sie den Speicheradressraum für 32-Bit-Anwendungen

Durch die Vergrößerung des Speicheradressraums können Windows-32-Bit- Versionen von Produkten wie unserem Website-Analysator mehr als 2 Gigabyte Speicher adressieren.

- http://www.microsoft.com/whdc/system/platform/server/PAE/PAEmem.mspx

- Speicherunterstützung und Windows-Betriebssysteme - http://blogs.msdn.com/oldnewthing/archive/2004/08/05/208908.aspx

- Der oft missverstandene /3GB-Schalter - http://blogs.msdn.com/oldnewthing/archive/2004/08/10/211890.aspx

- Mythos: Ohne /3GB kann ein einzelnes Programm nicht mehr als 2GB virtuellen Speicher zuweisen - http://blogs.msdn.com/slavao/archive/2006/03/12/550096.aspx

- Achtung: 4GB VAS unter WOW, lohnt sich das wirklich? - http://support.microsoft.com/kb/291988/

– Eine Beschreibung der 4-GB-RAM-Tuning-Funktion und des Schalters zur Erweiterung der physischen Adresse - http://msdn.microsoft.com/library/default.asp?url=/library/en-us/dngenlib/html/msdn_ntvmm.asp

- Der Virtual-Memory Manager in Windows NT (Hinweis: Nur für sehr technisch versierte)