|

|

Gennemgå og opret XML-sitemaps af store websteder

Scan meget store hjemmesider med mange sider. Forbedring af hastighed og hukommelsesforbrug under crawl. Opret tekst, HTML, RSS og XML sitemaps.

Almindelige webstedsårsager til brug af crawlerhukommelse

Hvis A1 Sitemap Generator fryser under scanning, fordi den kræver mere hukommelse ( eller kræver bedre konfiguration ), vil du måske først tjekke, om årsagen og løsningen findes på webstedet.

Liste over ting, der skal tjekkes:

Bemærk: Hvis du har brug for udvidet hjælp til at analysere dit websted for problemer, tilbyder vi også sitemap- og SEO-tjenester.

Liste over ting, der skal tjekkes:

- Tjek, om dit websted genererer en uendelig mængde af unikke URL'er. Hvis det gør det, vil det få crawleren til aldrig at stoppe, da der hele tiden findes nye unikke side-URL'er. En god metode til at opdage og løse den slags problemer er ved at:

- Start en hjemmesidescanning.

- Stop hjemmesidescanningen efter fx en halv time.

- Undersøg om alt ser korrekt ud, dvs. om de fleste af de fundne URL'er virker korrekte.

Eksempel #1

Et websted returnerer 200 i stedet for 404 for ødelagte side-URL'er. Eksempel på uendeligt mønster:

Originale 1/broken.html links til 1/1/broken.html links til 1/1/1/broken.html osv.

Eksempel #2

Webstedsplatformens CMS genererer et stort antal 100 % duplikerede URL'er for hver faktisk eksisterende URL. Se denne hjælpeside for at læse mere om duplikerede URL'er. Husk, at du kan analysere og undersøge intern hjemmesidelink, hvis noget ser forkert ud. - Tjek, om din projektkonfiguration og dit websteds indhold vil få crawleren til at downloade hundrede af megabyte store filer.

Eksempel #1: Dit websted indeholder mange enorme filer (som hundredvis af megabyte), som crawleren skal downloade. (Mens hukommelsen er frigivet, efter at overførslen er fuldført, kan det stadig forårsage problemer på computere med lav hukommelse).

Bemærk: Hvis du har brug for udvidet hjælp til at analysere dit websted for problemer, tilbyder vi også sitemap- og SEO-tjenester.

Crawlerhastighed og webserverydelse

Webserver- og databasehastighed er vigtig, hvis du bruger databasegenereret indhold. Fora, portaler og CMS-baserede websteder udløser ofte mange SQL-forespørgsler pr. HTTP-anmodning. Baseret på vores erfaring er her nogle eksempler på flaskehalse i webserverens ydeevne:

Tjek, om databasens ydeevne er den primære flaskehals, når den rammes af mange samtidige forbindelser og forespørgsler. Sørg desuden for, at databasen ikke er begrænset (f.eks. gennem licensen) ved maksimalt samtidige brugere/anmodninger.

Hvis du læser/skriver til filer/ressourcer, kan dette stoppe andre forbindelser, hvis de kræver adgang til de samme ressourcer.

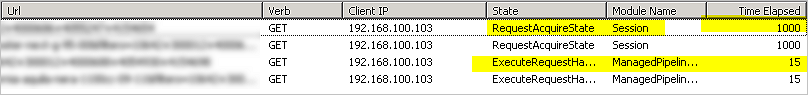

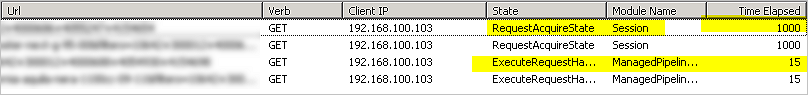

På IIS- webserver kan læsning/skrivning af sessionsinformation blive sat i kø ved hjælp af en låsemekanisme - dette kan forårsage problemer, når der håndteres en høj belastning af HTTP-anmodninger fra den samme crawlersession på tværs af mange sider samtidigt.

Tjek dine webserverlogfiler og scan dit websted til tider med lavt båndbreddeforbrug.

Database

Tjek, om databasens ydeevne er den primære flaskehals, når den rammes af mange samtidige forbindelser og forespørgsler. Sørg desuden for, at databasen ikke er begrænset (f.eks. gennem licensen) ved maksimalt samtidige brugere/anmodninger.

Ressourcer og filer

Hvis du læser/skriver til filer/ressourcer, kan dette stoppe andre forbindelser, hvis de kræver adgang til de samme ressourcer.

Ressourcer og sessioner

På IIS- webserver kan læsning/skrivning af sessionsinformation blive sat i kø ved hjælp af en låsemekanisme - dette kan forårsage problemer, når der håndteres en høj belastning af HTTP-anmodninger fra den samme crawlersession på tværs af mange sider samtidigt.

Scan, når trafikken er lav

Tjek dine webserverlogfiler og scan dit websted til tider med lavt båndbreddeforbrug.

Valg af den korrekte eksekverbare

A1 Sitemap Generator-opsætningsfilen installerer flere eksekverbare filer i programinstallationsbiblioteket, hver optimeret til forskellige systemer. Mens opsætningsinstallationen vil vælge den, der passer bedst til dit computersystem, vil du måske bruge en af de andre i tilfælde af for høj hukommelsesbrug.

Listen over installerede eksekverbare filer:

Listen over installerede eksekverbare filer:

- Sitemap_64b_UC.exe / Sitemap_64b_W2K.exe :

- Fuld understøttelse af Unicode med 64bit eksekverbar.

- Minimum kræver: Windows XP / 64bit.

- Størst hukommelsesforbrug, men kan også få adgang til meget mere hukommelse, hvis den er tilgængelig.

- Sitemap_32b_UC.exe / Sitemap_32b_W2K.exe :

- Fuld understøttelse af Unicode med 32bit eksekverbar.

- Minimumkrav: Afhængigt af version enten Windows XP / 32 bit eller Windows 2000 / 32 bit.

- Noget lavere hukommelsesforbrug.

- Sitemap_32b_CP.exe / Sitemap_32b_W9xNT4.exe :

- Noget understøttelse af Unicode med 32bit eksekverbar.

- Minimumkrav: Windows 98 / 32bit.

- Laveste hukommelsesforbrug.

Crawler-konfiguration

Ændring af indstillinger kan gøre en stor forskel, hvis du oplever problemer som:

Reducer det samlede og/eller maksimale ressourceforbrug på crawlercomputeren:

Reducer det samlede ressourceforbrug på crawler- og webservercomputer:

Mindsk topressourceforbrug på crawler- og webservercomputer:

Når du bruger pause / genoptag webstedsscanningsfunktionalitet:

Mindsk ressourceforbrug på webservercomputer:

Ting, der kan påvirke ressourceforbruget på både server og desktop:

Bonustip : Hvis du har en stor hjemmeside kan det ofte være en god idé at lave et par testscanninger. På den måde kan du konfigurere URL-ekskluderingsfiltre, før du starter en større webstedscrawl.

- Scanning af hjemmeside går meget langsomt.

- Webserveren afbryder forbindelser, hvilket forhindrer crawleren i at få alle sider.

- Du har store websteder med 10.000 eller 100.000 (+) sider, du ønsker at scanne.

Reducer det samlede og/eller maksimale ressourceforbrug på crawlercomputeren:

- Deaktiver Scan websted | Dataindsamling | Opret logfil over webstedsscanninger

- Deaktiver Scan websted | Dataindsamling | Bekræft, at eksterne URL'er findes

- Deaktiver Scan websted | Dataindsamling | Gem fundne eksterne URL'er

- Deaktiver Scan websted | Dataindsamling | Gem omdirigeringer, links fra og til alle sider osv.

- Deaktiver Scan websted | Dataindsamling | Gem yderligere detaljer (f.eks. hvilken linje i URL-indhold et link er placeret)

- Deaktiver Scan websted | Dataindsamling | Undersøg URL'er for at finde sprog, hvis det er nødvendigt for at identificere

- Deaktiver Scan websted | Dataindsamling | Gem titler for alle sider

- Deaktiver Scan websted | Dataindsamling | Gem "meta"-beskrivelse for alle sider

- Deaktiver Scan websted | Dataindsamling | Gem "meta" søgeord for alle sider

- Deaktiver Scan websted | Dataindsamling | Gem og brug "fallback"-tags til titel og beskrivelse, hvis det er nødvendigt

- Deaktiver Scan websted | Dataindsamling | Gem ankertekst til alle links

- Deaktiver Scan websted | Dataindsamling | Gem "alt"-attribut for alle "anvendelser"

- Deaktiver Scan websted | Crawler muligheder | Crawl fejlsider

- Deaktiver Scan websted | Crawler muligheder | Tillad cookies

- Deaktiver Scan websted | Webmaster filtre | Overhold "robots.txt" fil "crawl delay" direktivet

- Overvej at prøve Scan hjemmeside | Crawler motor | HTTP ved hjælp af WinInet-motor og indstillinger (Internet Explorer)

- Deaktiver Værktøjer | i topmenuen Efter webstedsscanninger: Beregn oversigtsdata (udvidet)

- Deaktiver Værktøjer | i topmenuen Efter hjemmesidescanninger: Åbn og vis data Opret sitemap åbnes i stedet.

Reducer det samlede ressourceforbrug på crawler- og webservercomputer:

- In Scan hjemmeside | Analysefiltre og Scan hjemmeside | Udgangsfiltre ;

- Konfigurer, hvilke mapper og sider webstedscrawler kan ignorere:

- Mange fora genererer sider med lignende eller duplikeret indhold.

- Ekskludering af URL'er kan spare mange HTTP-anmodninger og båndbredde.

- Se hjælpen til analysefiltre og outputfiltre.

- Følgende sker, når en URL ekskluderes:

- Kun analysefiltre : Standardindstillingen er HEAD i stedet for GET for HTTP-anmodningerne

- Kun outputfiltre : Standarder for at fjerne den ekskluderede URL, efter at webstedsgennemgangen er afsluttet.

- Både analysefiltre og outputfiltre : Ingen HTTP-anmodning overhovedet til den ekskluderede URL.

- Konfigurer, hvilke mapper og sider webstedscrawler kan ignorere:

Mindsk topressourceforbrug på crawler- og webservercomputer:

- In Scan hjemmeside | Crawler motor

- Maks. samtidige forbindelser (dataoverførsel):

- Indstil om webserver backend og din egen båndbredde kan håndtere flere anmodninger.

- Indstil hvis webserver backend (f.eks. databaseforespørgsler) er en flaskehals.

- Max arbejdstråde (overførsel, analyse osv.):

- Indstil om din egen computer CPU kan klare mere arbejde.

- Sæt ned, hvis du laver andet arbejde på din computer.

- Juster timeoutindstillinger:

- Milisekunder at vente, før læsning timeout.

- Milisekunder at vente, før forbindelsen timeout.

- Tilslutningsforsøg før opgivelse.

- Sådan ændrer du indstillinger:

- Indstil, hvis du vil sikre dig, at du får fat i alle links og sider.

- Sæt ned, hvis du ønsker, at scanningen af hjemmesiden skal være så hurtig som muligt.

- Aktiver/deaktiver brug af vedvarende forbindelser.

- Aktiver/deaktiver GZip- komprimering af alle data, der overføres mellem crawler og server.

- Aktiver/deaktiver vedvarende forbindelser, som påvirker, hvordan klient/server kommunikerer.

- I indstillingen Standard stitype og handler eksperimenterer mellem at bruge Indy og WinInet til HTTP.

- Maks. samtidige forbindelser (dataoverførsel):

Når du bruger pause / genoptag webstedsscanningsfunktionalitet:

- In Scan hjemmeside | Output filtre :

- Se hjælp om outputfiltre.

- Fjern markeringen i Scan websted | Udgangsfiltre | Når webstedsscanningen stopper: Fjern ekskluderede webadresser :

- Får webstedscrawleren til at beholde alle URL'er. Dette sikrer, at ingen URL testes mere end én gang.

- URL'er, der er ekskluderet af noget i outputfiltre, tagges og ignoreres stadig, når der oprettes sitemaps.

- In Scan hjemmeside | Webmaster filtre :

- Se hjælp om webmasterfiltre.

- Fjern markeringen i Scan websted | Webmaster filtre | Når webstedsscanningen stopper: Fjern URL'er med noindex/disallow :

- Får webstedscrawleren til at beholde alle URL'er. Dette sikrer, at ingen URL testes mere end én gang.

- URL'er, der er ekskluderet af noget i webmasterfiltre, tagges og ignoreres stadig, når der oprettes sitemaps.

- Se nedenfor vedrørende GET versus HEAD- anmodninger, og hvordan dette kan påvirke effektiviteten af genoptage.

Mindsk ressourceforbrug på webservercomputer:

- Brug en indholdsleveringsnetværksløsning (forkortet CDN ) til serverindhold uden at belaste din egen server.

Ting, der kan påvirke ressourceforbruget på både server og desktop:

- In Scan hjemmeside | Crawler motor

- Aktiver/deaktiver ved hjælp af GET- anmodninger (i stedet for HEAD efterfulgt af GET ). Hvis du planlægger at bruge CV- funktionalitet, vil du måske aktivere brugen af HEAD- anmodninger, da det giver webstedscrawleren mulighed for hurtigt at løse fundne webadresser. Dette fremskynder til gengæld antallet af sider, der er fuldt analyseret. På grund af det indre af crawlermotoren kan brug af HEAD også reducere hukommelsesforbruget.

Bonustip : Hvis du har en stor hjemmeside kan det ofte være en god idé at lave et par testscanninger. På den måde kan du konfigurere URL-ekskluderingsfiltre, før du starter en større webstedscrawl.

Projektfiler og projektdatalagring

- Hvis du har problemer med at indlæse et webstedsprojekt med udvidede webstedsdata :

- Projektdata gemmes i en undermappe til projektfilen.

- Projektfil: c:\example\projects\demo.ini.

- Projektdatamappe: c:\eksempel\projekter\demo\.

- Slet projektfiler, der indeholder udvidede webstedsdata:

- hotarea-normal-ex.xml.

- hotarea-external-ex.xml.

- Prøv at indlæse projektfilen igen.

- Projektdata gemmes i en undermappe til projektfilen.

- Forbedre hastighed og hukommelsesforbrug, når du gemmer/indlæser projekter:

- I topmenuen Indstillinger for gem/indlæs projekt:

- Brug optimeret XML-datalagring.

- Ekskluder udvidede webstedsdata.

- Begræns data til sitemap-URL'er.

- I topmenuen Indstillinger for gem/indlæs projekt:

Din computerkonfiguration

- Jo større hjemmesiden er, jo vigtigere bliver hukommelsen.

- Hardwarehukommelse er meget hurtigere end virtuel hukommelse.

- Under scanning af websteder bliver masser af data gemt i hukommelsen.

- Hvis du har et gigantisk websted, så overvej at øge hukommelsesadressepladsen som forklaret i dens eget afsnit nedenfor.

- Hvis du har problemer med båndbredden, kan du prøve følgende:

- Udfør webstedsscanninger om natten, når din internetudbyder har få onlinebrugere.

- Sørg for, at ingen download- applikationer kører.

Øg hukommelsesadresseplads til 32-bit applikationer

Øget hukommelsesadresseplads gør det muligt for Windows 32-bit -versioner af produkter såsom vores sitemap-generator at adressere mere end 2 gigabyte hukommelse.

- http://www.microsoft.com/whdc/system/platform/server/PAE/PAEmem.mspx

- Hukommelsesstøtte og Windows-operativsystemer - http://blogs.msdn.com/oldnewthing/archive/2004/08/05/208908.aspx

- Den ofte misforståede /3GB-switch - http://blogs.msdn.com/oldnewthing/archive/2004/08/10/211890.aspx

- Myte: Uden /3GB kan et enkelt program ikke tildele mere end 2GB virtuel hukommelse - http://blogs.msdn.com/slavao/archive/2006/03/12/550096.aspx

- Vær opmærksom: 4 GB VAS under WOW, er det virkelig det værd? - http://support.microsoft.com/kb/291988/

- En beskrivelse af funktionen til indstilling af 4 GB RAM og omskifteren til fysisk adresseudvidelse - http://msdn.microsoft.com/library/default.asp?url=/library/en-us/dngenlib/html/msdn_ntvmm.asp

- Virtual-Memory Manager i Windows NT (Bemærk: Kun for de meget tekniske)